Ollama:LLM本地部署利器Ollama简介

![图片[1]-Ollama:LLM大语言模型本地部署利器-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723399328961_0.png)

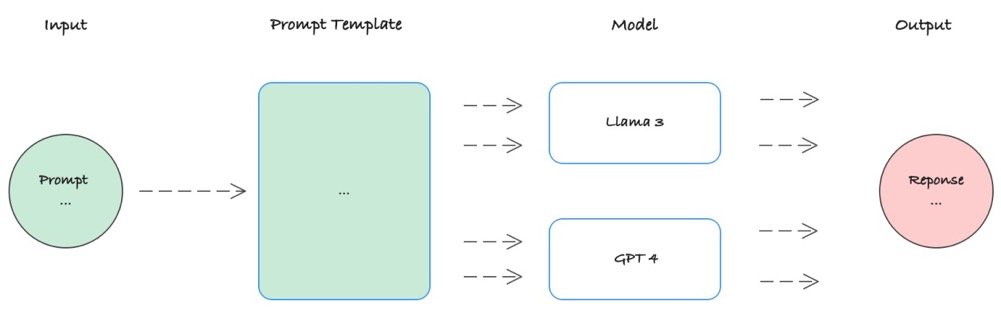

Ollama是一款提供在本地无缝运行开源LLM大语言模型的优秀工具,专注于本机LLM大模型部署运行环境,以满足用户个性化体验需求。Ollama提供了类似OpenAI协议的API接口和聊天界面,可以非常方便地在本地快速部署各类LLM大语言模型,并通过接口或者界面体验。Ollama支持LLM模型的热加载,以及无需重新启动就可切换不同的模型体验。Ollama支持开源社区众多模型,如:Llama2、Code Llama、Qwen、Gemma等众多LLM模型。Ollama支持的LLM模型列表可以在官网查询:。下面列出部分常用知名LLM模型列表。

![图片[2]-Ollama:LLM大语言模型本地部署利器-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723399328961_1.png)

注意:运行7B模型至少需要8GB的RAM,运行13B模型需要16GB的RAM,而运行33B模型需要32GB的RAM。

Ollama安装

Ollama已经提供了多平台部署支持,包括windows、MacOS、Linux、Docker多环境多系统,并且能够快速的安装体验。

Ollama体验

•RESTAPI指南

•Modelfile:是一个类似Dockerfile书写格式定义LLM模型启动,如:

![图片[3]-Ollama:LLM大语言模型本地部署利器-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723399328961_2.png)

基础案例如下:

FROM llama2# sets the temperature to 1 [higher is more creative, lower is more coherent]PARAMETER temperature 1# sets the context window size to 4096, this controls how many tokens the LLM can use as context to generate the next tokenPARAMETER num_ctx 4096# sets a custom system message to specify the behavior of the chat assistantSYSTEM You are Mario from super mario bros, acting as an assistant.

Ollama体验

本文内容使用MacOS安装包运行体验,首先点击启动ollama应用。然后则可以通过ollama run qwen:1.8b运行qwen1.8B模型,ollama将会自动拉取下载模型并启动qwen模型服务。

![图片[4]-Ollama:LLM大语言模型本地部署利器-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723399328961_3.png)

然后就可以通过命令行与大模型交互。

![图片[5]-Ollama:LLM大语言模型本地部署利器-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723399328961_4.png)

也可以使用curl访问API体验:

curl http://127.0.0.1:11434/api/chat -d '{"model": "qwen:1.8b","messages": [{ "role": "user", "content": "实现java快速排序算法" }],"stream": false}'

![图片[6]-Ollama:LLM大语言模型本地部署利器-JieYingAI捷鹰AI](https://www.jieyingai.com/wp-content/uploads/2024/08/1723399328961_5.png)

附录

© 版权声明

THE END